La Inteligencia Artificial (IA) es una tecnología que cambia las reglas del juego para cualquier industria y sociedad.

Los beneficios de la IA son transversales a la sociedad y a los países. Esta tecnología consigue mejorar el bienestar de la población, avanzar en los objetivos de sostenibilidad medioambiental, agilizar la acción humanitaria o ayudar a preservar el patrimonio cultural. También puede ayudar a optimizar el sistema sanitario, facilitando la detección de enfermedades y promoviendo soluciones a medida de cada estudiante o empleado favoreciendo la inclusión y la adaptación a las características del mercado de trabajo.

Su uso en el ámbito empresarial ya está transformando sectores industriales, posibilitando nuevos modelos de negocio, modificando la forma de investigar e innovar y redefiniendo nuevas capacidades y formas de trabajar. La IA permite:

- tomar decisiones rápidas basadas en datos

- optimizar los procesos de fabricación y gestión

- mientras minimiza los costes operativos y genera eficiencias

Sin embargo, su diseño y uso no está exento de riesgos. El mayor reto al que nos enfrentamos hoy es diseñar un modelo de gobernanza para la IA que pueda aprovechar todo su potencial al tiempo que protege los derechos humanos, las democracias y el Estado de Derecho.

Inteligencia Artificial e IA Generativa

Posicionamiento 2024.

Inteligencia Artificial

Innovación, ética y regulación.

El alcance de la Inteligencia Artificial no se limita a las fronteras nacionales y, por tanto, requiere de soluciones y enfoques globales. Es pues el momento de promover una convergencia a escala regional y mundial, incluyendo la determinación de principios éticos.

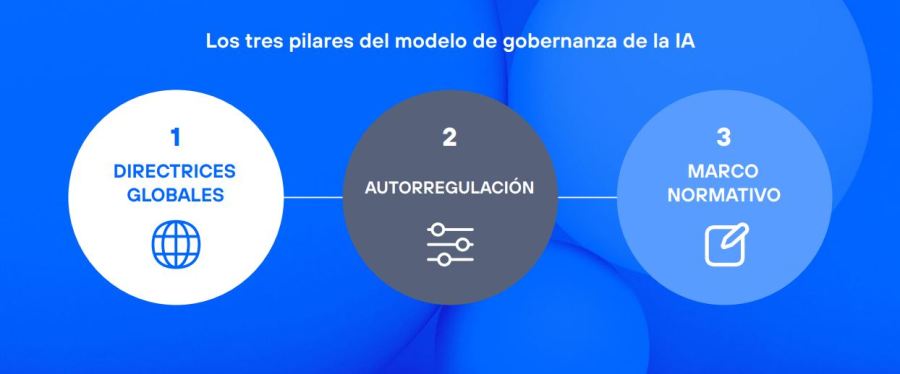

El planteamiento requiere de una visión holística con un modelo de gobernanza equilibrado y coherente basado en tres pilares: directrices globales, autorregulación y una regulación basada en riesgos.

Todo ello con el doble objetivo de mitigar los riesgos, generando confianza en los ciudadanos y garantizando su salud, su seguridad y sus derechos, a la vez que se promueve la innovación y la adopción de la tecnología.

Modelo de gobernanza: de principios éticos a su aplicación

Telefónica aprobó unos principios éticos para la IA de aplicación en toda la compañía. Estos principios se aplican desde el diseño y abarca su desarrollo incluyendo el uso de productos y servicios por parte de los empleados de la compañía, así como los proveedores y terceras partes.

Recurso Relacionado

La aplicación de estos principios se base en un enfoque de “Responsabilidad desde el Diseño”, que nos permite incorporar criterios éticos y sostenibles en toda la cadena de valor. Es un modelo de gobernanza basado en tres niveles: