Europa acaba de publicar la Ley de Inteligencia Artificial, una propuesta para regular los usos de la Inteligencia Artificial (IA) con el fin de abordar adecuadamente los beneficios y riesgos de esta tecnología a nivel de la Unión. Este reglamento pretende crear un espacio seguro para la innovación en IA que cumpla con un alto nivel de protección del interés público, la seguridad y los derechos y libertades fundamentales, al tiempo que crea las condiciones para un ecosistema de confianza que fomente la adopción de servicios de IA.

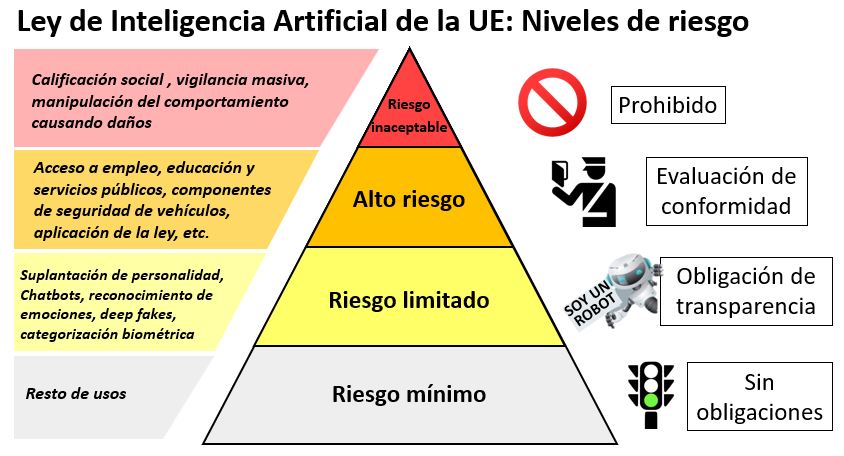

La propuesta sigue un enfoque basado en el riesgo, lo que significa que se aplicarán determinadas obligaciones y restricciones en función del nivel de riesgo derivado del uso de la IA. Esto sigue las recomendaciones de las Directrices Éticas para una Inteligencia Artificial Fiable, el Libro Blanco de la UE sobre la IA y las aportaciones realizadas por Telefónica y muchas otras partes interesadas en las consultas públicas europeas sobre la IA.

El reglamento identifica explícitamente cuatro niveles de riesgo. El nivel superior comprende los usos que presentan un riesgo inaceptable para la seguridad, los medios de vida y los derechos de las personas. Estos casos de uso están prohibidos a menos que estén autorizados por la ley con fines de seguridad nacional e incluyen los sistemas de IA de puntuación social, la manipulación del comportamiento humano que causa daño y la vigilancia masiva.

(Fuente: Elaboración propia)

El segundo nivel, incluyendo los usos de alto riesgo, se someterá a una evaluación de conformidad antes de que puedan desplegarse en el mercado. La evaluación de la conformidad examina la calidad de los conjuntos de datos para minimizar los riesgos y los resultados discriminatorios, la documentación y el mantenimiento de registros para la trazabilidad, la transparencia y información proporcionada a los usuarios, la supervisión humana, la solidez, la precisión y las disposiciones de ciberseguridad. La UE ha definido una lista de usos de la IA que se considerarían de alto riesgo, como el acceso al empleo, la educación y los servicios públicos, la gestión de infraestructuras críticas, los componentes de seguridad de los vehículos, la aplicación de la ley y la administración de justicia, etc.

El tercer nivel está compuesto por los usos de riesgo limitado y sólo tendrá obligaciones de transparencia. Por ejemplo, en el caso de los “chatbots” basados en IA, los usuarios deben ser conscientes de que están interactuando con una máquina.

Por último, el cuarto nivel incluye usos de riesgo mínimo que no estarán sujetos a ninguna obligación, aunque se recomienda la adopción de códigos de conducta voluntarios. Estos códigos de conducta podrían aumentar la confianza para la adopción de la IA y proporcionar una palanca para la diferenciación de los servicios y, por tanto, una ventaja competitiva entre los proveedores de servicios.

En general, el reglamento propuesto parece adecuado para proporcionar un entorno de confianza para que Europa lidere la adopción y el uso de sistemas de IA innovadores en los que se protejan los derechos y las libertades de acuerdo con los valores de la UE.

La Ley de IA abre la supervisión y la evaluación de la conformidad -no en todos los casos- a terceros, que tendrán acceso a los datos utilizados para entrenar los sistemas de IA e incluso al código fuente o a los algoritmos. Esto supone un cambio de paradigma, ya que estos organismos analizarán datos personales y confidenciales, secretos comerciales y código fuente protegido por derechos de propiedad intelectual. Estos amplios poderes de supervisión tendrán que ir acompañados de una responsabilidad a la par y de la adopción de principios de proporcionalidad y minimización de las intervenciones. En términos globales, la necesidad de obligaciones proporcionadas es un área de preocupación, que podría abordarse mediante una identificación más granular de los usos de alto riesgo. Esto evitaría etiquetar como de alto riesgo usos no tan problemáticos, librándoles de la imposición una carga desproporcionada sin efecto real en la mejora de la confianza y dando lugar a un aumento de los costes de desarrollo y del tiempo de comercialización. Además, podría poner a los desarrolladores europeos en desventaja competitiva frente a otros, especialmente cuando se dirigen a mercados no europeos.

El reglamento será aplicable a todos los usos de la IA que afecten a los ciudadanos de la UE, independientemente de la sede del proveedor de servicios o del lugar donde se desarrolle o ejecute el sistema, dentro o fuera de las fronteras de la UE. Este es también el caso de otros reglamentos de la UE, como el RGPD (Reglamento General de Protección de Datos), y otras propuestas legislativas, como la DMA (Digital Markets Act) y la DSA (Digital Services Act).

A pesar de la diferencia de fondo, el RGPD podría darnos algunas pistas sobre cuestiones que deberían abordarse desde el principio. Una decisión judicial ha anulado el acuerdo entre la UE y EE.UU. que proporcionaba seguridad jurídica sobre el cumplimiento del RGPD de un marco para las transferencias de datos personales entre las regiones. Además, un organismo consultivo no vinculante, la Junta Europea de Protección de Datos, ha expresado su preocupación por los mecanismos alternativos de transferencia de datos, al tiempo que ha formulado recomendaciones adicionales que, de adoptarse, podrían inhibir aún más las transferencias de datos. Esto ha colocado a las empresas en una situación jurídicamente compleja hasta que adapten las transferencias de datos a estos nuevos desarrollos, al tiempo que aumenta la incertidumbre sobre los posibles requisitos adicionales para que las transferencias internacionales de datos cumplan con el RGPD.

Dado que la nueva Ley Europea de Inteligencia Artificial sería aplicable, por ejemplo, a los servicios de IA ofrecidos desde terceros países a los ciudadanos de la UE, es muy relevante cómo se va a aplicar este reglamento, se va a evaluar la conformidad y la supervisión para estos casos. De hecho, esto es lo que pone de manifiesto el caso del RGPD entre EE.UU. y la UE: lo importante que es aclarar y facilitar la aplicación extraterritorial de los reglamentos de la UE. Es necesaria a plena cooperación entre la UE y los terceros países para garantizar la compatibilidad de los resultados normativos, permitiendo marcos flexibles que aseguren el cumplimiento normativo y evaluaciones de conformidad que proporcionen seguridad jurídica con los procedimientos menos gravosos posibles.

Para que la UE tenga éxito y lidere el desarrollo, la adopción y el uso de una Inteligencia Artificial basada en valores europeos, debe ser prioritaria una aplicación fluida de la Ley de Inteligencia Artificial con todas las garantías jurídicas para las partes afectadas fuera de las fronteras de la UE.

Ahora, la propuesta se presentará al Consejo Europeo y al Parlamento para su aprobación por el procedimiento legislativo europeo ordinario. Aunque el proceso no se completará antes de 2023, la UE debería fomentar un proceso rápido para que la Ley de Inteligencia Artificial entre en vigor en el momento oportuno para la adopción masiva de una IA que está totalmente alineada con los valores de la UE respetando los derechos y libertades fundamentales.